Spark Streaming概述

1. Spark Streaming简介

Spark Streaming是一个准实时(秒,分钟)、微批次(batch)的数据处理框架。Spark Streaming支持的数据输入源很多,例如:Kafka、Flume、Twitter、ZeroMQ和简单的TCP套接字等等。数据输入后可以用Spark的高度抽象原语(算子的另外一种叫法,和之前做区分)如:map、reduce、join、window等进行运算。而结果也能保存在很多地方,如HDFS,数据库等。如图所示: 和Spark基于RDD的概念很相似,Spark Streaming使用离散化流(discretized stream)作为抽象表示,叫作DStream。DStream是随时间推移而收到的数据的序列。在内部,每个时间区间收到的数据都作为RDD存在,而DStream是由这些RDD所组成的序列(因此得名"离散化")。所以简单来讲,DStream就是对RDD在实时数据处理场景的一种封装。

和Spark基于RDD的概念很相似,Spark Streaming使用离散化流(discretized stream)作为抽象表示,叫作DStream。DStream是随时间推移而收到的数据的序列。在内部,每个时间区间收到的数据都作为RDD存在,而DStream是由这些RDD所组成的序列(因此得名"离散化")。所以简单来讲,DStream就是对RDD在实时数据处理场景的一种封装。

2. Spark Streaming的特点

- 易用: 使用高层封装的算子进行构建应用

- 容错:开箱即用的精准一次语义特性支持

- 易整合到Spark体系:流批一体的支持和交互式的API使用

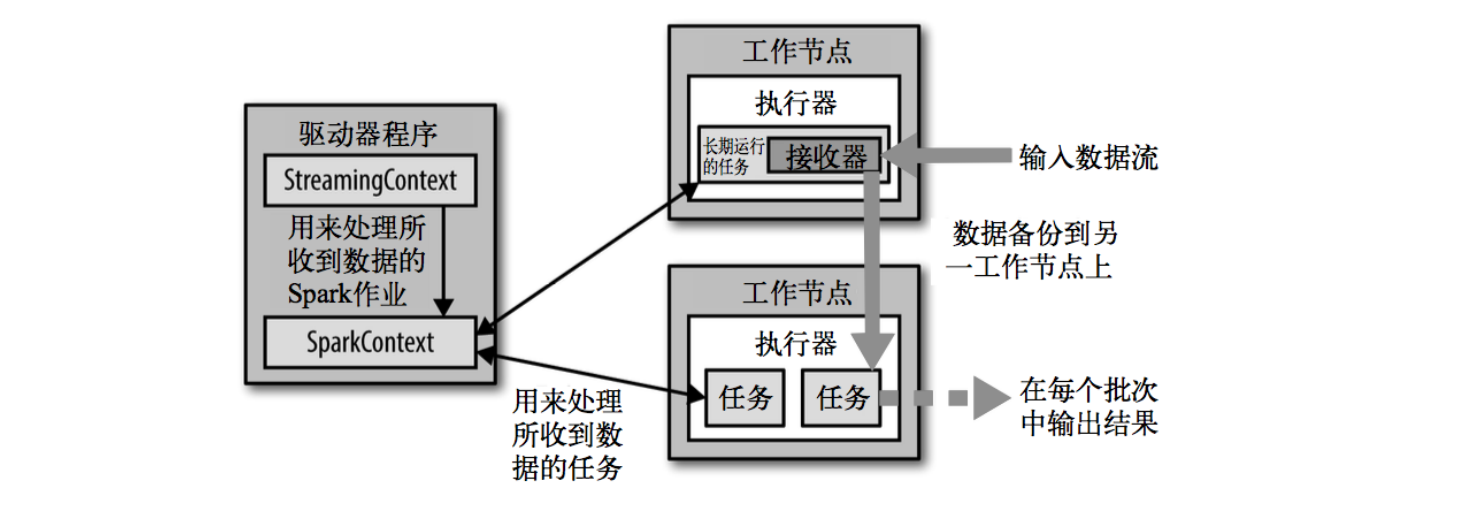

3. Spark Streaming架构

4. 背压机制

Spark 1.5以前版本,用户如果要限制Receiver的数据接收速率,可以通过设置静态配制参数spark.streaming.receiver.maxRate的值来实现,此举虽然可以通过限制接收速率,来适配当前的处理能力,防止内存溢出,但也会引入其它问题。比如:producer数据生产高于maxRate,当前集群处理能力也高于maxRate,这就会造成资源利用率下降等问题。

为了更好的协调数据接收速率与资源处理能力,1.5版本开始Spark Streaming可以动态控制数据接收速率来适配集群数据处理能力。背压机制(即Spark Streaming Backpressure): 根据JobScheduler反馈作业的执行信息来动态调整Receiver数据接收率。

通过属性spark.streaming.backpressure.enabled来控制是否启用backpressure机制,默认值false,即不启用。